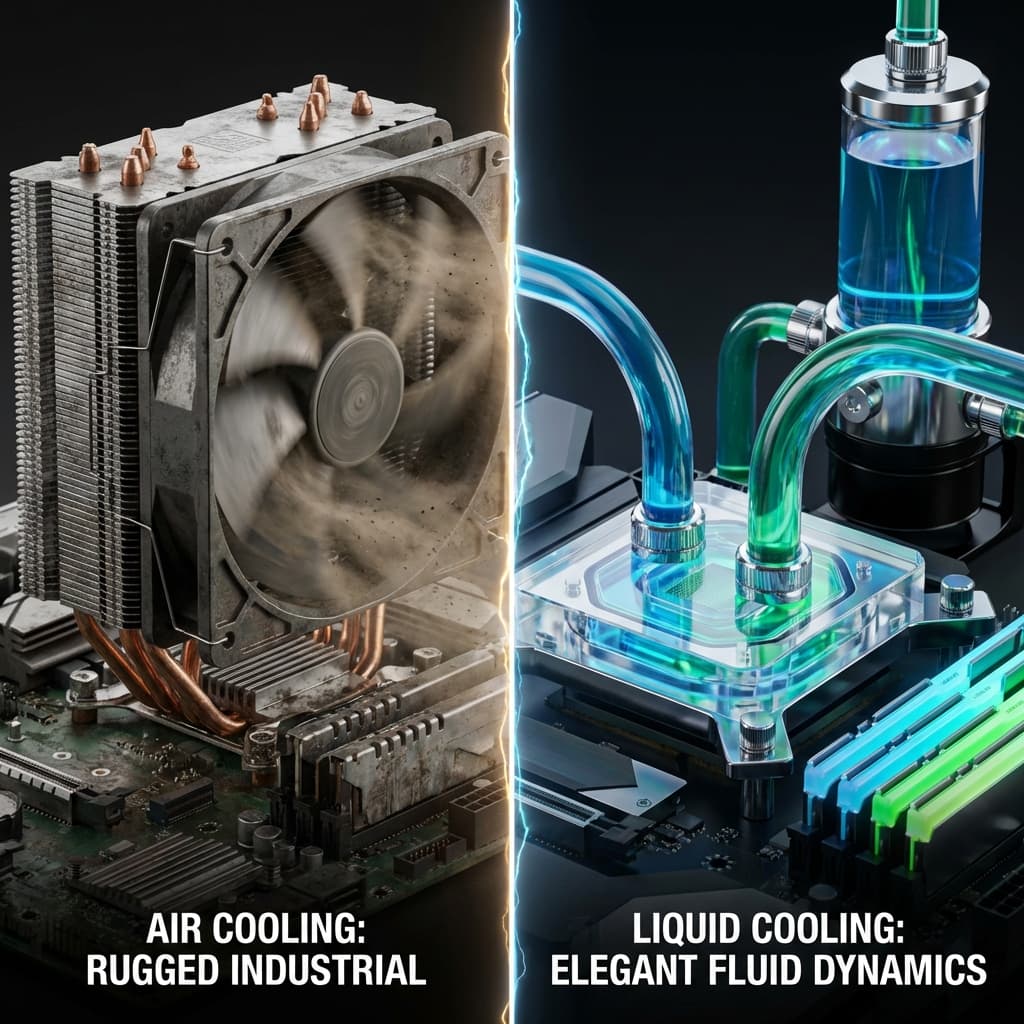

쿨링 시스템: 공랭 vs 수랭

내 컴퓨터가 여름만 되면 비행기 이륙 소리를 내는 이유. 선풍기 바람(공랭)과 찬물 샤워(수랭) 중 무엇을 선택해야 할까? 써멀구리스 바르다 망한 경험담.

내 컴퓨터가 여름만 되면 비행기 이륙 소리를 내는 이유. 선풍기 바람(공랭)과 찬물 샤워(수랭) 중 무엇을 선택해야 할까? 써멀구리스 바르다 망한 경험담.

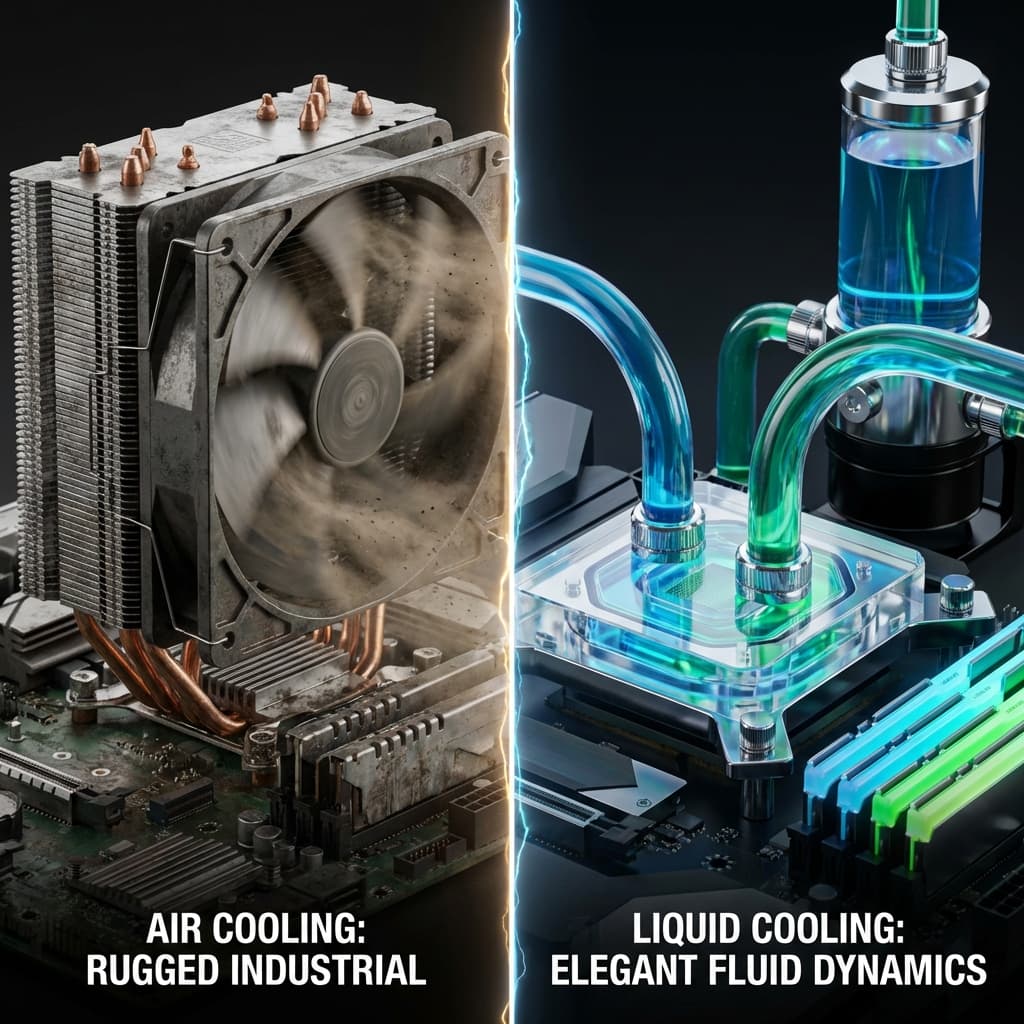

맥북 배터리는 왜 오래 갈까? 서버 비용을 줄이려면 AWS Graviton을 써야 할까? 복잡함(CISC)과 단순함(RISC)의 철학적 차이를 정리해봤습니다.

AI 시대의 금광, 엔비디아 GPU. 도대체 게임용 그래픽카드로 왜 AI를 돌리는 걸까? 단순 노동자(CUDA)와 행렬 계산 천재(Tensor)의 차이로 파헤쳐봤습니다.

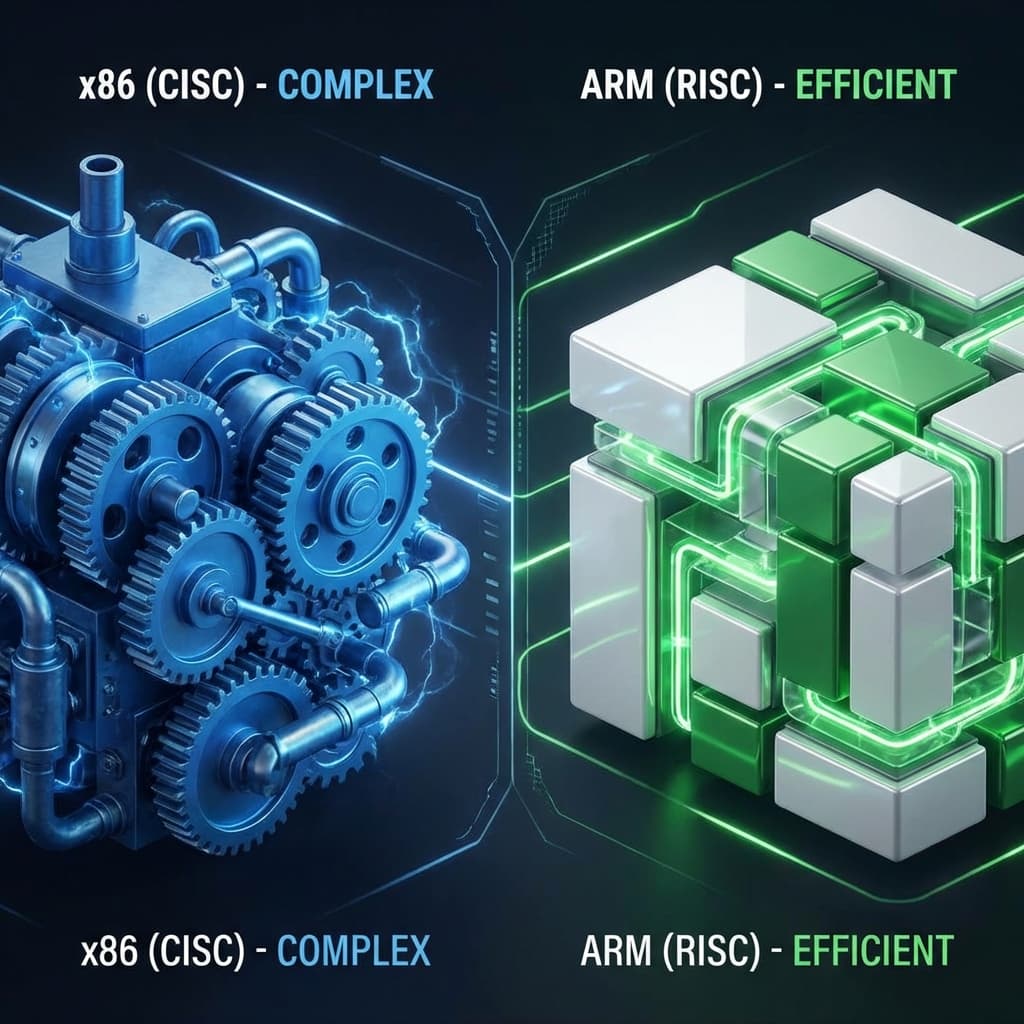

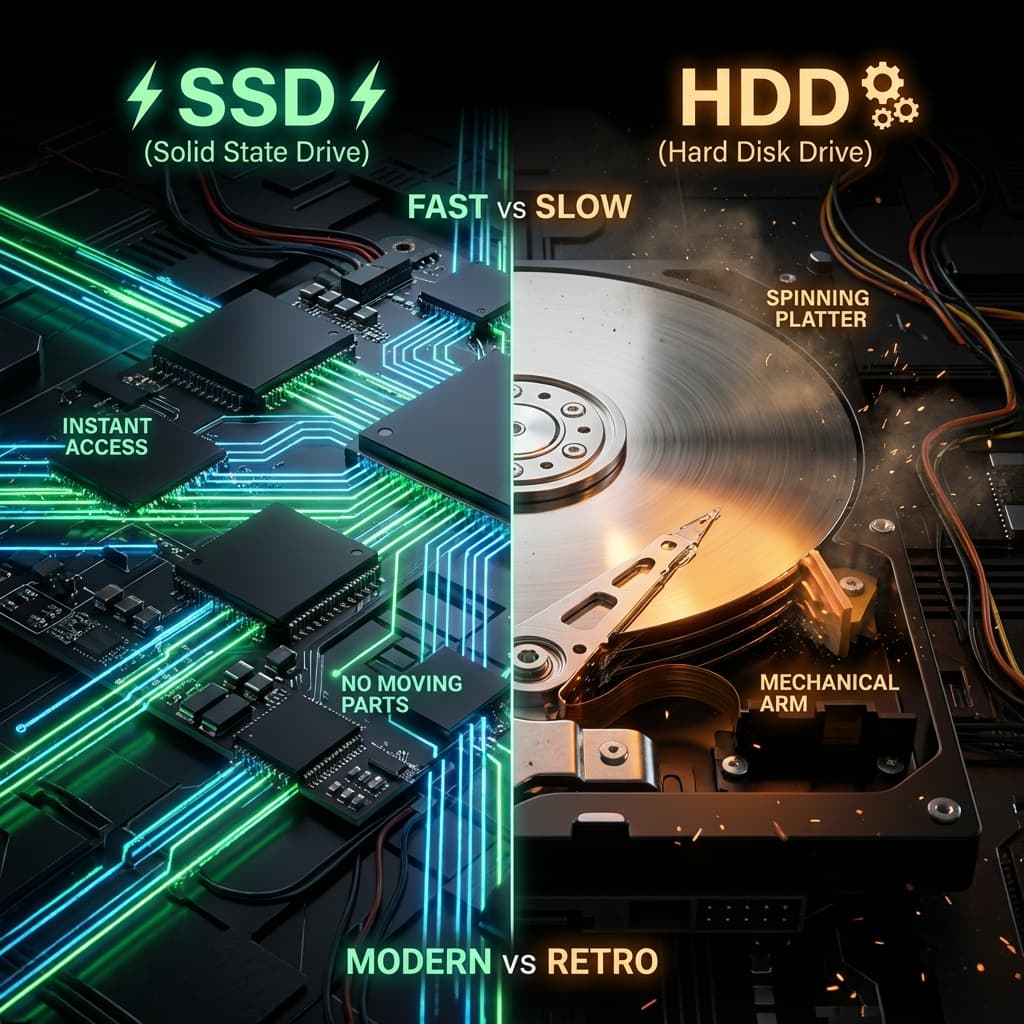

빠른 SSD를 샀는데 왜 느릴까요? 1차선 시골길(SATA)과 16차선 고속도로(NVMe). 인터페이스가 성능의 병목이 되는 이유.

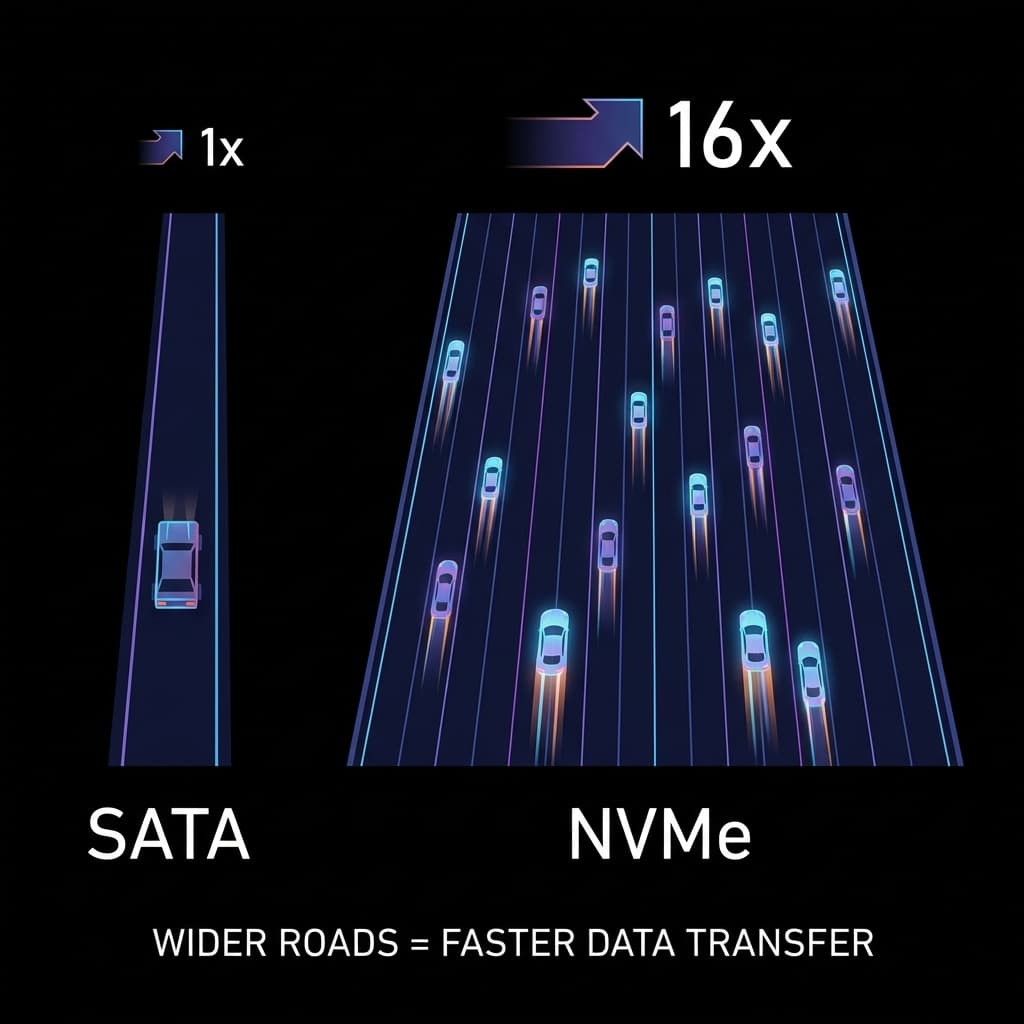

LP판과 USB. 물리적으로 회전하는 판(Disc)이 왜 느릴 수밖에 없는지, 그리고 SSD가 어떻게 서버의 처리량을 100배로 만들었는지 파헤쳐봤습니다.

한여름에 고사양 게임을 돌리는데, 30분만 지나면 컴퓨터가 픽픽 꺼졌습니다. 케이스 옆면을 열어보니 열기가 훅 끼쳤습니다. 마치 사우나 같았습니다. CPU 온도를 확인해보니 95도를 찍고 있었습니다. 이게 쿨링(Cooling)의 중요성을 처음 깨달은 순간이었습니다.

컴퓨터 부품은 전기를 먹고 '열'이라는 배설물을 내뿜습니다. 이 배설물을 빨리 치워주지 않으면, 부품은 자기 자신을 보호하기 위해 작동을 멈춥니다(Throttling/Shutdown). 고사양 노트북으로 개발하다가 빌드가 느려지는 이유도 결국 이거였다. 써멀 쓰로틀링 때문에 CPU가 스스로 성능을 낮추는 거였습니다.

쿨링을 이해하려면 고등학교 물리 시간으로 돌아가야 합니다. 열은 항상 뜨거운 곳에서 차가운 곳으로 이동합니다. 이동 방식은 딱 3가지입니다.

전도 (Conduction): 핫팩을 만지면 따뜻하죠? 물질(고체)을 타고 직접 이동하는 것입니다. CPU에서 히트싱크 바닥으로 열이 전달되는 방식이 바로 전도입니다. 구리나 알루미늄 같은 금속이 열전도율이 높아서 쿨러 재질로 쓰입니다.

대류 (Convection): 국을 식힐 때 입으로 불죠? 공기나 물(유체)이 순환하며 열을 가져가는 것입니다. 히트싱크 핀에서 공기로 열이 퍼지는 방식이 대류입니다. 바람이 강할수록 열 배출이 빨라집니다.

복사 (Radiation): 난로 쬐면 따뜻하죠? 매질 없이 빛(적외선) 형태로 퍼지는 것입니다. 컴퓨터 쿨링에선 비중이 적지만, 케이스 표면에서 외부로 열이 방출되는 방식이 복사입니다.

이 세 가지 원리를 이해하면 쿨링 시스템이 왜 그렇게 설계되었는지 와닿았다. CPU → 써멀구리스(전도) → 히트파이프(전도) → 히트싱크 핀(전도+대류) → 공기/물(대류) → 케이스 밖(대류+복사). 모든 쿨링은 이 체인을 따라갑니다.

"그냥 CPU 위에 쿨러 쇠덩이를 얹으면 되는 거 아냐?" 절대 안 됩니다. 현미경으로 보면 금속 표면은 달표면처럼 울퉁불퉁합니다. 그 사이에는 공기(Air)가 끼어있는데, 공기는 열을 차단하는 단열재입니다. 패딩 점퍼가 따뜻한 이유도 공기층 때문입니다.

써멀구리스는 이 미세한 공기층을 메워주는 열 전도성 액체입니다. 이걸 콩알만큼 짜서 빈틈을 메워주니 온도가 20도나 뚝 떨어집니다. 없으면 CPU는 1분 내로 사망합니다.

처음에 써멀구리스를 너무 많이 발라서 옆으로 흘러내린 적이 있었습니다. 메인보드에 튀어서 한참 청소했습니다. 콩알만큼만, 중앙에 살짝 올려두고 쿨러로 눌러서 자연스럽게 퍼지게 하는 게 정석입니다. 너무 적으면 커버리지가 부족하고, 너무 많으면 오히려 열전도율이 떨어집니다.

써멀구리스도 종류가 다양합니다. 실리콘 베이스, 금속 베이스(액체금속), 세라믹 베이스 등. 액체금속(Liquid Metal)은 열전도율이 가장 높지만, 알루미늄을 부식시키기 때문에 구리 히트싱크에만 써야 합니다. 잘못 쓰면 쿨러가 녹아내립니다. 이런 디테일을 받아들였다니, 이제 하드웨어 마니아 반열에 오른 기분입니다.

가장 흔한 방식입니다.

히트파이프는 마법 같은 물건입니다. 내부에 미량의 액체가 들어있는데, 열을 받으면 증발하고 찬 곳에서 다시 액화됩니다. 모세관 현상으로 액체가 순환하면서 열을 빠르게 전달합니다. 전원 없이도 작동하는 수동형 쿨링의 핵심입니다.

장점:도저히 온도가 안 잡혀서 큰맘 먹고 수랭 쿨러(AIO, All-In-One)를 샀습니다. 원리는 보일러와 똑같았습니다.

확실히 조용하고 강력했습니다. 공랭이 '부채질'이라면, 수랭은 '찬물 등목'이었습니다. 하지만 "혹시 물 새서 컴퓨터 다 터지면 어떡하지?"라는 공포감은 덤이었습니다. 실제로 5년 정도 쓰면 펌프 수명이 다하거나 미세하게 증발해서 바꿔줘야 합니다.

냉각수는 보통 증류수에 부식방지제(Inhibitor)와 색소를 섞은 겁니다. AIO는 밀폐형이라 교체가 불가능하지만, 커스텀 수랭은 주기적으로 교체해야 합니다. 안 하면 관 내부에 조류(Algae)가 자라거나 부식이 생깁니다. 투명 튜브에 초록색 이물질이 보이면 완전히 망한 겁니다.

장점:실제로 쿨링이 제대로 작동하는지 확인하려면 온도 모니터링이 필수입니다. 리눅스 서버에서 센서 값을 읽어보겠습니다.

# lm-sensors 설치 (Ubuntu/Debian)

sudo apt-get install lm-sensors

# 센서 감지 (처음 한 번만)

sudo sensors-detect

# 온도 확인

sensors

# 출력 예시:

# coretemp-isa-0000

# Adapter: ISA adapter

# Package id 0: +52.0°C (high = +80.0°C, crit = +100.0°C)

# Core 0: +49.0°C (high = +80.0°C, crit = +100.0°C)

# Core 1: +51.0°C (high = +80.0°C, crit = +100.0°C)

이 명령어로 실시간 온도를 볼 수 있습니다. Package id는 CPU 전체 온도이고, Core 0/1은 각 코어의 온도입니다. 고부하 시 80도 넘어가면 쿨링을 점검해야 합니다. 100도에 도달하면 쓰로틀링이 발동합니다.

팬 속도도 제어할 수 있습니다.

# fancontrol 설치

sudo apt-get install fancontrol

# PWM 팬 설정 마법사

sudo pwmconfig

# 팬 속도 확인

sensors | grep fan

# fan1: 1200 RPM

# fan2: 1500 RPM

# 수동으로 팬 속도 조절 (0-255, 255=100%)

echo 150 | sudo tee /sys/class/hwmon/hwmon0/pwm1

노트북에서 개발하다가 빌드 돌릴 때 팬이 쉴 새 없이 돌아가는 게 싫어서, 스크립트로 온도 기반 팬 제어를 만든 적이 있습니다. 60도 이하면 조용히, 80도 이상이면 풀파워로 돌리는 식입니다. 이렇게 직접 제어해보니 쿨링의 원리가 확실히 정리해본다.

네이버나 구글의 데이터센터는 전기세의 40%를 냉각에 씁니다. 수만 대의 서버가 24시간 돌아가니 열이 엄청납니다. 데이터센터 쿨링은 완전히 다른 게임입니다.

서버를 마주 보게 배치하지 않고, 등지게 배치합니다. 찬 공기가 들어가는 길(Cold Aisle)과 뜨거운 공기가 나오는 길(Hot Aisle)을 철저히 분리해서 효율을 극대화합니다.

Cold Aisle에는 차가운 공기만 흐르게 하고, Hot Aisle에는 뜨거운 배기만 모읍니다. 두 공기가 섞이지 않게 Containment(격리벽)를 설치하기도 합니다. 이 설계만으로도 냉각 효율이 30% 이상 향상됩니다.

실제로 데이터센터 투어를 간 적이 있는데, Hot Aisle에 들어가니 숨이 막힐 정도로 뜨거웠습니다. 60도는 넘었을 겁니다. 반대로 Cold Aisle은 에어컨 바람이 쌩쌩 불어서 반팔 입고는 못 있을 정도였습니다. 온도 차이가 극명했습니다.

데이터센터 효율 지표입니다. 전체 전력 소비 / IT 장비 전력 소비로 계산합니다. 1.0에 가까울수록 냉각에 낭비되는 전기가 없다는 뜻입니다.

예를 들어 IT 장비가 100kW를 쓰고, 냉각 시스템이 50kW를 쓰면 PUE는 1.5입니다. 구글이나 페이스북 같은 초대형 데이터센터는 1.11.2를 달성합니다. 엄청나게 효율적입니다. 보통 중소형 데이터센터는 1.52.0 수준입니다.

PUE를 낮추려면 외기(Outside Air)를 활용합니다. 겨울철 추운 공기를 끌어와서 냉각에 쓰는 겁니다. 프리 쿨링(Free Cooling)이라고 합니다. 북유럽이나 아이슬란드에 데이터센터가 많은 이유입니다. 전기세도 싸고 추워서 냉각비가 거의 안 듭니다.

대형 데이터센터는 천장에 수백 개의 온도 센서를 달아서 실시간 Heat Map을 그립니다. 어느 랙이 뜨거운지 한눈에 보입니다. 특정 랙이 이상하게 뜨거우면 서버 고장이나 팬 고장을 의심합니다. 이런 모니터링 시스템을 직접 보니, 데이터센터 운영이 과학이라는 걸 이해했다.

수조(Reservoir), 펌프, 워터블록, 라디에이터, 튜브를 직접 디자인해서 만듭니다. RGB 조명 넣고 투명 튜브 쓰면 엄청 예쁩니다. 하지만 조립이 악몽입니다. 튜브 길이 잘못 재면 누수 나고, 피팅(이음매) 하나 잘못 조이면 냉각수가 줄줄 샙니다.

친구가 커스텀 수랭 만들다가 첫 가동 시 누수로 그래픽카드 사망한 적이 있습니다. 100만원 날렸습니다. 그 뒤로는 AIO만 씁니다. 예쁘지만 리스크가 큽니다.

전기가 통하지 않는 특수 오일(3M Novec, Mineral Oil 등) 속에 서버를 통째로 담가버립니다. 공기보다 열전도율이 1000배 높아서 팬이 필요 없습니다. 가장 조용하고 효율이 압도적입니다.

실제로 암호화폐 채굴장이나 슈퍼컴퓨터에서 씁니다. 어항 같은 탱크에 메인보드가 담겨있고 기름이 부글부글 끓는 모습이 신기했습니다. 소음이 0입니다. 열 배출도 극도로 효율적입니다.

단점은 청소가 지옥입니다. 부품 하나 교체하려면 기름 다 빼고, 부품 닦고, 다시 넣고, 기름 채워야 합니다. 기름값도 비쌉니다. 일반인은 쓸 일 없습니다.

오버클러킹 신기록 세울 때 씁니다. 영하 196도의 액체 질소를 들이붓습니다. CPU를 얼려서 전자의 이동 저항을 극도로 낮춥니다. 7GHz 넘는 클럭도 가능합니다.

하지만 몇 분밖에 못 씁니다. 질소가 계속 증발하니 계속 부어야 합니다. 손에 묻으면 동상입니다. 유튜브에서 오버클러킹 대회 보면 장갑 끼고 질소 통을 계속 부어댑니다. 완전히 쇼입니다. 실용성은 0입니다.

돈 한 푼 안 쓰고 온도를 낮추는 비기입니다. "CPU야, 너 밥(전압) 너무 많이 먹어. 조금만 줄이자." 반도체 수율에 따라 여유 마진이 있는데, 이 마진만큼 전압을 깎는 겁니다. 성능은 그대로 유지하면서 -10도 효과를 볼 수 있습니다. 단, 너무 깎으면 블루스크린 뜹니다.

리눅스에서 언더볼팅하는 예시입니다.

# Intel CPU 언더볼팅 (intel-undervolt 사용)

sudo apt-get install intel-undervolt

# 설정 파일 편집

sudo nano /etc/intel-undervolt.conf

# 예시 설정 (밀리볼트 단위로 감소)

# undervolt 0 'CPU' -100

# undervolt 1 'GPU' -75

# undervolt 2 'CPU Cache' -100

# 적용

sudo intel-undervolt apply

# 안정성 테스트 (stress test)

stress-ng --cpu 4 --timeout 60s

sensors

제 노트북에 언더볼팅을 걸었더니 풀로드 시 온도가 85도에서 75도로 떨어졌습니다. 팬 소음도 확 줄었습니다. 전력 소비도 줄어서 배터리 타임이 30분 늘었습니다. 공짜로 얻는 효과치고 대단했습니다.

다만 너무 공격적으로 깎으면 시스템이 불안정해집니다. -100mV부터 시작해서 -10mV씩 늘려가며 안정성을 테스트해야 합니다. 블루스크린 뜨면 너무 깎은 겁니다. 다시 올려야 합니다.

| 구분 | 공랭 (Air Cooling) | 수랭 (Liquid Cooling) |

|---|---|---|

| 냉각 매체 | 공기 (바람) | 액체 (냉각수) |

| 소음 | 팬 속도에 따라 시끄러움 | 비교적 조용함 (펌프 소음 있음) |

| 리스크 | 없음 (반영구적) | 누수(침수) 위험, 펌프 고장 |

| 가격 | 2-5만원 (타워형 기준) | 10-25만원 (AIO 기준) |

| 추천 대상 | 일반 사용자, 서버(안정성) | 하드코어 게이머, 오버클러커 |

서버실(데이터센터)이 왜 에어컨을 빵빵하게 틀고 시끄러운 팬 소리로 가득한지 이해가 갔습니다. 거긴 물 새면 큰일 나니까 무조건 공랭을 쓰거든요. 최근엔 액침 냉각도 쓰지만 여전히 소수입니다. 제 개발용 맥북이 조용한 건, 알루미늄 바디 자체가 거대한 방열판 역할을 해주기 때문이라는 것도 알게 되었습니다. 애플은 팬을 최소화하고 히트싱크와 케이스를 최대화했습니다.

A: CPU 온도가 너무 높아져서(보통 100도) 물리적 손상이 우려될 때, 클럭 속도(성능)를 강제로 낮춰서 발열을 억제하는 보호 기능입니다. 게임 프레임이 갑자기 뚝 떨어지는 원인 1순위입니다. 빌드가 느려지는 것도 마찬가지입니다.

A: 팬이 1분에 도는 횟수(RPM)가 높을수록 풍량은 세지지만 소음은 로그 스케일로 커집니다. 그래서 큰 팬(140mm)을 천천히 돌리는 것이 작은 팬(80mm)을 빨리 돌리는 것보다 조용하고 효율적입니다.

A: IT 장비가 100kW를 쓸 때, 냉각 등 부대 시설에 10kW밖에 안 쓴다는 뜻입니다. 엄청나게 효율적인 수치입니다. 보통 데이터센터는 1.52.0 수준입니다. 구글이나 AWS 같은 초대형 데이터센터가 1.11.2를 달성합니다.

A: 내부에 소량의 액체가 들어있고, 뜨거운 쪽에서 증발하고 찬 쪽에서 응결하며 열을 전달합니다. 모세관 현상으로 액체가 순환하니 전원 없이도 작동합니다. 패시브 쿨링의 기술입니다.

A: 금속 표면은 미세하게 울퉁불퉁해서 공기층이 생깁니다. 공기는 단열재라서 열전도를 방해합니다. 써멀구리스는 이 공기층을 메워서 열전도율을 극대화합니다. 없으면 온도가 20도 이상 올라갑니다.

"차가운 머리, 뜨거운 가슴." 개발자는 반대여야 합니다. 머리(CPU)는 차갑게, 가슴(열정)은 뜨겁게. 여러분의 소중한 장비가 비명(팬 소음)을 지르지 않게, 오늘 먼지 청소라도 한번 해주는 건 어떨까요?

쿨링은 단순히 온도를 낮추는 것 이상입니다. 부품 수명을 늘리고, 성능을 최대한 뽑아내고, 전기세를 아끼는 겁니다. 여름철 노트북 무릎에 올려놓고 작업하다가 허벅지가 따끈해지는 경험, 다들 있으시죠? 그게 쿨링이 부족한 신호입니다. 쿨링 패드 하나 사거나, 책받침으로 밑을 띄워서 통풍을 개선하면 온도가 확 떨어집니다.

이제 쿨링의 원리를 완벽히 정리해봤습니다. 전도, 대류, 복사. 써멀구리스, 히트파이프, 라디에이터. 공랭과 수랭의 차이. 데이터센터의 PUE. 언더볼팅까지. 이 모든 게 결국 하나의 목표를 향합니다. 열을 빨리, 효율적으로, 조용히 버리자.