Attention 메커니즘: AI에게 '집중력'을 선물한 기술 (feat. Transformer)

RNN의 한계인 '치매 증상'을 극복하고, 구글이 'Attention Is All You Need' 논문으로 세상을 뒤집은 이야기. 쿼리(Query), 키(Key), 밸류(Value)의 완벽한 도서관 검색 비유와 멀티 헤드 어텐션, 그리고 Vision Transformer까지 연결합니다.

RNN의 한계인 '치매 증상'을 극복하고, 구글이 'Attention Is All You Need' 논문으로 세상을 뒤집은 이야기. 쿼리(Query), 키(Key), 밸류(Value)의 완벽한 도서관 검색 비유와 멀티 헤드 어텐션, 그리고 Vision Transformer까지 연결합니다.

둘 다 같은 Transformer 자식인데 왜 다를까? '빈칸 채우기'와 '이어 쓰기' 비유로 알아보는 BERT와 GPT의 결정적 차이. 프로젝트에서 겪은 시행착오와 선택 가이드.

머신러닝 모델 학습 시 겪은 과적합(Overfitting) 문제와 해결 과정을 공유합니다. 훈련 데이터 정확도 99%에 속아 배포했다가 참패한 경험과, Dropout, Regularization, Data Augmentation을 통해 '진짜 지능'을 만드는 방법을 설명합니다.

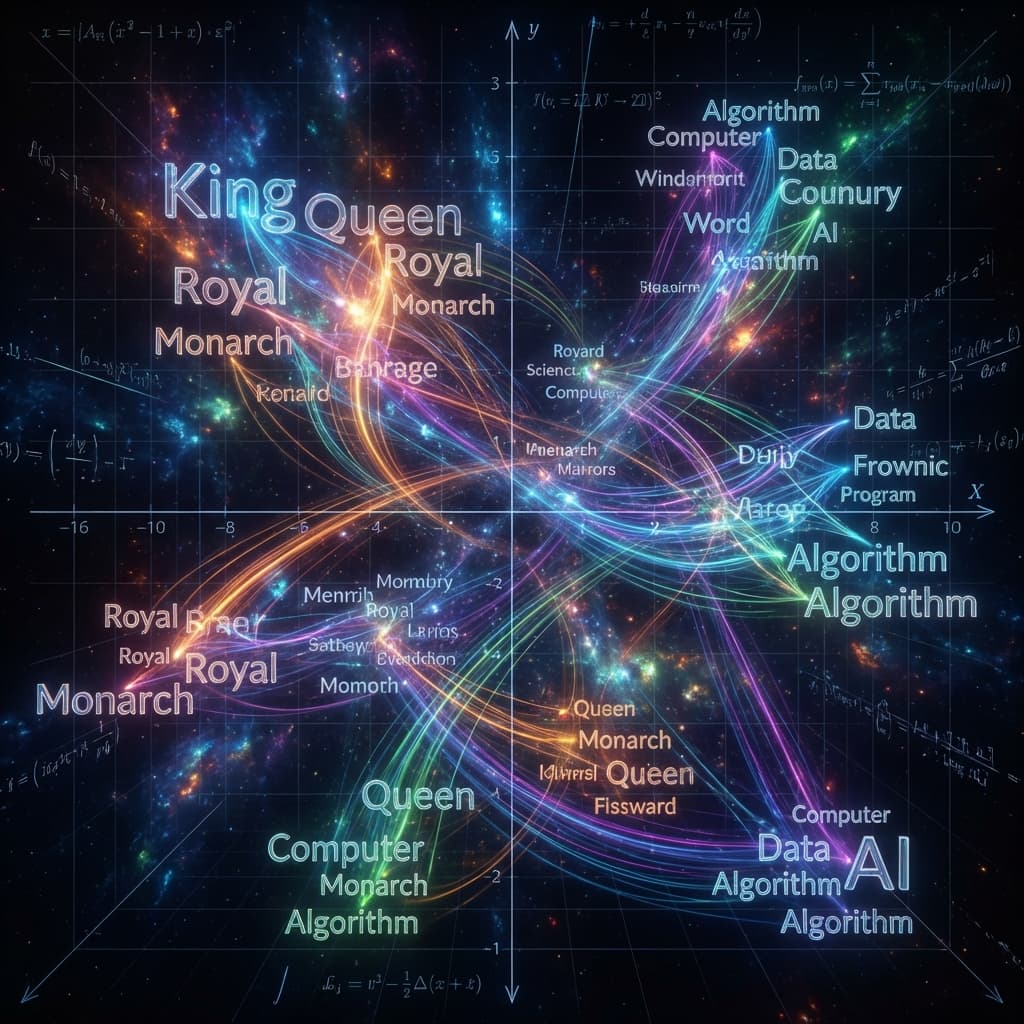

컴퓨터는 '사과'와 '배'가 비슷한 과일이라는 것을 어떻게 알까요? 원-핫 인코딩의 한계부터 Word2Vec, 그리고 현대 AI의 핵심인 트랜스포머(Transformer) 기반 임베딩까지. 텍스트를 숫자로 변환하여 의미를 계산하는 임베딩의 세계와 이를 활용한 RAG(검색 증강 생성) 아키텍처를 다뤄봤습니다.

인공지능이 이미지를 인식하는 마법의 열쇠, CNN의 모든 것을 파헤칩니다. 픽셀 덩어리에서 의미를 찾아내는 컨볼루션(Convolution)과 풀링(Pooling)의 수학적 원리부터, LeNet, AlexNet, ResNet으로 이어지는 딥러닝의 진화 과정, 그리고 자율주행과 의료 영상 분석 등 실제 활용 사례까지 쉽고 깊이 있게 설명합니다.